O grupo DecolonizAI é composto de pesquisadores, residentes no Brasil e em outras partes do mundo, interessados em investigar como os modos de colonização vêm acontecendo através das tecnologias emergentes.Na perspectiva decolonial o humano não está no centro, pois em primeiro lugar não existe um único tipo de humano capaz de representar a todos, em segundo lugar, o bem-estar social e ambiental depende de entender o humano como parte de um todo onde a ética do cuidado é o cuidado com si mesmo em consonância com o cuidado com outres e tudo ao nosso redor.

A forte antropomorfização da IA não está apenas no conceito de inteligência, ou a cópia do mesmo, mas na própria linguagem que remete a memórias, vivências e sentimentos dos mais variados. Assim, a colonização através da IA se dá também pela linguagem, seus sistemas de classificação e representação inclusos no modo de fazer científico, incluindo as imagens em bancos de dados que influenciam as identidades, sentimentos de pertencimento ou exclusão no imaginário do cotidiano. (DecolonizAI, 2023)

Entendemos que o termo “Inteligência Artificial” (IA) se tornou abrangente, tanto para a definição de diversas tecnologias que utilizam grande volume de dados e aprendizado de máquina, como também um tema de interesse para diversos campos do conhecimento.

Devido ao seu amplo alcance, a IA possui grandes impactos na sociedade, desde o trabalho, comportamento, saúde, educação, direito, assim como na natureza e na cultura.

Nos últimos meses, o mundo vem sendo surpreendido com os rápidos avanços da inteligência artificial baseada em processamento de linguagem natural. O encantamento causado pelas possibilidades da IA suplantar os seres humanos com maior rapidez e eficiência na produção de textos para variados fins nos deixa “no olho do furacão” e provavelmente com dificuldades para entender os impactos de tais tecnologias na vida, quando a criatividade e conhecimento humanos que colaboram para o aprimoramento das respostas da IA vêm sendo apropriados sem que, contudo, esteja claro quem estes desenvolvimentos beneficiam e como.

Enquanto especialistas e precursores dos estudos e treinamento da IA alertam sobre os possíveis perigos de ter decisões importantes fora do controle, permanecem obscuros quais seriam os maiores perigos, em especial aqueles que não estão sendo publicizados.

Nestes tempos, a sociedade civil informada, junto a governos e instituições educacionais e democráticas, vem se reunindo para formulações de políticas capazes de proteger vulneráveis e vulnerados dos possíveis impactos negativos da IA.

Algumas questões que antes permaneciam intocadas passam a ser mencionadas, como o entendimento de que as tecnologias não são neutras e tendem a representar os interesses de uma elite tecnológica que é majoritariamente composta de homens brancos do Norte global.

Do mesmo modo, as infraestruturas e os lucros concentram-se nas mãos desta elite.

Reacendem-se as discussões sobre de que modos o lucro ocorre e nos resta entender como a apropriação de dados, conhecimento, criatividade, trabalho e tempo vem se dando nos tempos atuais através da IA, por meios explícitos ou sutis.

Há alguns anos tem ficado mais evidente que preconceitos estruturais como racismo e misoginia se manifestam em algoritmos de recomendação e apoio na tomada de decisões. Reforçando estereótipos com características eugênicas, os algoritmos seguem uma lógica de exclusão e se apoiam em bases de dados nas quais a máquina pode apenas aprender como o mundo, em suas diversas esferas sociais, era no passado. Como as pessoas eram classificadas e de que forma. E, ainda, a disputa de narrativas com viés ideológico sempre ocorreu, ainda que de forma velada, na qual a lógica é que o conceito de “verdade” precisa ser único, independentemente se baseado ou não em evidências.

Ainda mais complexo, as evidências muitas vezes são forjadas, nem sempre de maneira explícita, como “plantar” uma prova de ato ilegal onde não havia prova, mas também de maneiras implícitas, como assediar com mais frequência as pessoas que já estão em situação vulnerável, de modo a criminalizá-las.

Tais situações produzem provas tendenciosas que não precisam ser questionadas, desde que confirmem narrativas comuns e recorrentes como algo que “faz sentido”. Ao que parece, precisamos voltar ao ponto de discutir como nascem os preconceitos e que elementos dentro da sociedade os fortalecem.

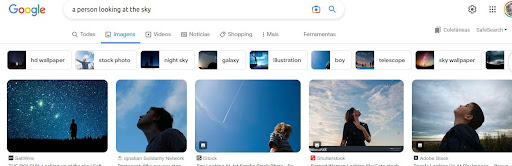

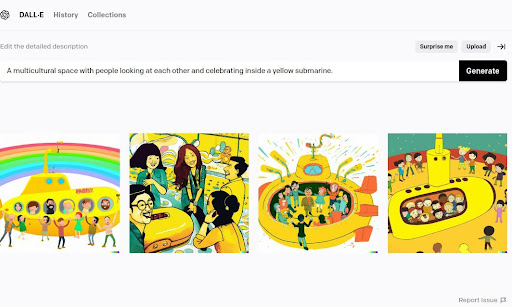

Por que há uma super-representatividade de pessoas negras, não brancas e pobres nas prisões? Por que há uma sub-representatividade destas mesmas pessoas como “agentes” quando buscamos na IA e nas imagens da web quaisquer atividades em que se coloque o termo “pessoa”, como, por exemplo, alguém observando o céu ou crianças brincando?

E, do mesmo modo, para muitas atividades e situações que envolvam o termo “pessoa” e “humano”, mulheres também aparecerão em menor número e, quando aparecem, em geral serão brancas, a não ser que a busca tenha conotações negativas. Outro aspecto é o de segregação. Embora nos diversos ambientes sociais a representatividade étnica entre as pessoas seja mais diversa, a IA irá apresentar mais pessoas brancas, quando não, asiáticas — a se pensar que países como a China, que ocupava o primeiro lugar em país mais populoso do mundo, até ser recentemente ultrapassada pela Índia, estão entre as grandes potências tecnológicas, investindo para que tenha estudantes e pesquisadores em universidades influentes do Norte global. Ou, de outro modo, quando for especificado uma determinada característica étnica, a IA tanto poderá ignorar e ilustrar com pessoas brancas, como também poderá criar uma situação segregada com apenas pessoas de uma etnia em ambientes sociais que costumam ser diversos.

– Reprodução via Dall-e/Open AI

Desse modo, entre os responsáveis pelo treinamento e engajamento sobre a curadoria de conteúdos da IA há mais brancos, quando não, asiáticos, e menos pessoas de etnias diversas que são características do Sul global. Outro aspecto é que uma grande quantidade da produção científica nesta área é feita por pessoas que estão em universidades localizadas nas regiões com maior poder sobre as infraestruturas tecnológicas.

Assim, a base de dados que as IAs de processamento de linguagem natural irá acessar também possui super-representações e sub-representações nas narrativas, interesses e perfis de estudo.

Olhando apenas o caso do Brasil, embora seja um país em que a maioria da população é negra ou não branca, os espaços de poder e decisão raramente representam tais características demográficas. Como, por exemplo, a maioria da população ser de mulheres (sem contabilizar as diferentes categorias femininas de transgêneros) e tal característica não refletir os espaços de poder e representação na sua vertente “geral”, “universal”.

O que os resultados em pesquisas triviais na IA e web irão demonstrar é que enquanto se buscou, no nível institucional, promover melhores compreensões sobre inclusão e respeito às pessoas e suas diferenças, sob uma ótica de direitos universais, as batalhas legais permaneceram ambíguas entre que direitos devem ser universais e quem poderá acessar estes direitos.

Ou seja, embora exista legislação sobre os variados tipos de assédio, o respeito aos direitos das mulheres, crianças, negros, indígenas, diversidades de gênero e orientações sexuais, há – na prática – uma ausência de atenção e cuidados com as questões de justiça, onde se fizesse valer a transparência nos processos de decisão, acesso à informação, entre tantos atributos éticos necessários e em consonância com o contrato social que rege o “espírito das leis” no imaginário do Ocidente.

A naturalização de injustiças históricas se perpetua nas relações de poder, quando biopolíticas estabelecem controles sobre os corpos e se refletem na “inteligência coletiva”. A lembrar que a conceituação de “inteligência” depende dos valores envolvidos para o entendimento do que seria inteligência. Trata-se de uma “inteligência coletiva” amplificada por mídias sociais onde acirram-se disputas de narrativas que não conseguem ser definidas por vertentes únicas como uma luta ideológica entre todos que querem questionar valores antigos contra os que querem preservar estruturas conservadoras (com o perdão da tríplice redundância).

Conservar pode ser um poço de preconceitos, como pode ser sabedoria ancestral ou uma cultura política (por exemplo, “ser de esquerda”). Não ser conservador pode tanto ser libertário como liberal econômico, anarcocapitalista, feminista, fetichista ou especista. Como categorizar estes grupos, senão entendendo que o caos é inevitável, sendo o único método possível o da complexidade?

Se tais contradições são inerentes aos grupos humanos contemporâneos, entender o que se compreende como “coletivo” se reduz a categorias formais que não explicam o comportamento dos indivíduos dentro dos coletivos e nem mesmo os coletivos.

A redução de pessoas a categorias específicas no ambiente virtual ainda carece de explicações explícitas. Isto é, elas precisariam estar não apenas disponíveis nas plataformas, como facilmente identificáveis. Uma vez entendendo em quais categorias um “usuário” está classificado, poderá buscar explicações mais acertadas, assim como identificar que fontes de informações podem estar adensando os rótulos que os identificam. Perfis psicológicos, perfis de consumidor, perfis profissionais. Como nos definem e sob quais parâmetros?

É importante compreender que os parâmetros não somente podem vir enviesados pelos olhares de quem manipula os algoritmos, mas que mesmo práticas metodológicas não são necessariamente neutras quando uma lógica reducionista tende a suprimir variáveis essenciais para a compreensão de todos aqueles que não fazem parte do que se considera padrão. Um exemplo muito simples: em seu livro Weapons of Math Destruction (2016), Cathy O’Neil menciona que o fato de uma pessoa estar dentro dos valores “aceitáveis de índice de massa corporal (IMC)” fazia com que empregadores pagassem o seguro-saúde de empregados, enquanto, do contrário, as pessoas teriam que pagar seu seguro-saúde. Este “recorte” acabava fazendo com que mulheres negras fossem as mais afetadas em número. A autora argumenta que o tipo de estrutura física da maior parte das mulheres negras tendia a um outro tipo de “equilíbrio” no IMC. Outros argumentos poderiam ser também acessados em tais casos. O fato é que contextos e especificidades explicam os fenômenos de maneiras distintas e as padronizações tendem a melhor se adequarem para um grupo demográfico específico, em geral o perfil branco do Norte global.

Pouco a pouco vamos entendendo que não há absoluta neutralidade na ciência e, ainda, que a lógica clássica requer respostas únicas, fazendo com que estimativas parciais ganhem status de verdade. Em adição, a fissura entre teoria e prática dentro do pensamento moderno eurocêntrico estimula a existência de campos obscuros inóspitos à transparência e explicabilidade. Para referendar conclusões em diversas áreas, acadêmicas, científicas, institucionais, o único meio possível é lançar mão da autoridade de poder julgar e decidir como uma soberania absoluta capaz de anular outras potências de soberanias.

Portanto, quando se requer da IA explicabilidade, que dados poderão treinar tal atributo? Onde as práticas humanas apontam para explicações e de que modo fazem isto? Que dados minimamente coerentes de explicabilidade podem ser computados? Digamos, a possibilidade de alguém estar gripado é a combinação de fatores como “nariz escorrendo” e “espirros”, “tosse”, fatos que ocorrem x% de vezes em outros ou todos os indivíduos que estão com gripe. Então este é um exemplo em que uma lógica de explicação é aplicada.

Desde sete anos atrás, um grupo de pesquisadores criou o software Lime para buscar explicar as decisões das redes neurais. Assim, digamos que, hipoteticamente, se uma imagem tinha 30% de chance de ser gato, 20% de ser jaguar, 15% de ser lobo, 10% de ser cachorro, 15% de ser onça e 10% de ser leoa, então, acessando outras correlações que indicavam casos de distribuição similares onde o resultado verdadeiro era gato, a explicação está em demonstrar esse processo anterior à decisão final do sistema.

Uma publicação do mesmo período (2016) irá demonstrar “surpresas ontológicas” apontadas como falha pelos engenheiros do Google, quando um alteres era apenas identificado na relação com a sua funcionalidade, ou seja, com as mãos nas posições de exercício físico. Do ponto de vista de uma simples identificação de um objeto não haveria problemas éticos. Porém, se tais modelos são aplicados para classificar humanos, os problemas éticos aparecem. Por exemplo, mulheres apenas associadas aos cuidados da casa e crianças, pessoas negras em posições subalternas ou mesmo em situações ofensivas, e assim por diante.

Outro aspecto em que os usos e impactos da IA são reforçados por desigualdades, fazendo-as transparecer, está nos problemas de acessibilidade aos recursos de infraestrutura para os mais variados locais do globo. Isso tanto se reflete nos indivíduos e territórios que não possuem recursos suficientes para terem dispositivos e conectividade virtual, até nos governos do Sul global que utilizam as infraestruturas de empresas situadas no Norte global. Desde que a economia se internacionalizou e as decisões que mais impactam o mundo estão refletidas na “nuvem” onde o mercado financeiro opera, naturalizou-se o fato de usar as infraestruturas das big techs, como se os benefícios dessa economia internacionalizada fossem divididos de maneira justa para outros territórios.

Entre os dez países mais populosos do mundo, o mercado brasileiro é corresponsável por grande concentração de renda nas mãos das elites tecnológicas.

É preciso mencionar que o fato de muitos grupos nos interiores do Brasil não possuírem acesso a uma conectividade não significa que a melhor solução é prover conectividade e dar dispositivos para todos. Os problemas essenciais no mundo hoje, que têm as tecnologias como protagonistas, analisando de maneira interseccional, dizem também respeito aos impactos ambientais.

Além dos impactos humanos nos problemas já identificados, mas que não são de fácil solução – visto que os usos de IA dizem respeito aos direitos essenciais que são o direito ao trabalho, à saúde, à educação, à moradia, à alimentação -, não tem sido fácil solucionar os problemas de vieses que se expressam em misoginia, racismo e outros preconceitos porque, ao que parece, os caminhos já avançados dos algoritmos podem estar perpetuando passos mal planejados em sua origem. Tomemos como exemplo os desafios de mobilidade em grandes cidades como São Paulo, onde um crescimento não planejado impacta o trânsito, e o fato de a cidade não poder parar torna difícil novas tentativas de replanejamento. Os algoritmos como planejamentos não conscientes dos seus possíveis impactos teriam também se desenvolvido por caminhos tortuosos onde é praticamente inviável voltar atrás?

Relevante lembrar que a IA envolve também mineração, impactos ambientais, trabalho semiescravo e diversos outros tipos de abusos e desrespeito aos direitos essenciais para uma vida digna. Problemas não exclusivos da IA e outras tecnologias emergentes, senão de relações de trabalho e (des)respeito à vida e à natureza no seu sentido mais amplo.

A interseccionalidade traz de volta a inspiração holística hyppie da ideologia californiana dos anos 1970, antes suprimida pelo hype yuppie do new age futurista dos anos de 1980, para uma maior evidência das questões ecológicas. Entretanto o protagonismo dos discursos em defesa da ecologia tem sido dos brancos, até que indígenas passam a ocupar maior espaço como o “lugar de fala” de um humano que tem corpo e mente integrados na natureza. Entenda-se como indígenas não apenas indígenas brasileiros, mas os indígenas africanos, australianos, norte-americanos.

Concordamos que a intenção de escrever um Manifesto por uma IA Decolonial se inicia com uma proposta de diálogo aberto onde são apresentadas uma série de provocações para questões inconclusivas como feitas pelo grupo que redigiu o AI Decolonial Manyfesto.

O texto do primeiro Manifesto DecolonizAI, divulgado em março de 2023, menciona que um grupo europeu de desenvolvedores de IA sugere que o CERN (Organização Europeia para Pesquisa Nuclear) ou outra organização similar deve se ocupar de coordenar o desenvolvimento em larga escala da IA, garantindo sua transparência e segurança. Tal preocupação indica que os impactos da IA estão sendo compreendidos como de alto risco. Contudo, acreditamos que a compreensão sobre o alto risco envolve variáveis complexas, a se considerar os impactos cognitivos e subjetivos como reflexos de mudanças de paradigma profundas no cenário cultural.

Foi também mencionado que, uma vez que não dispomos de infraestruturas no Sul global, estamos, como sempre estivemos em relação à maior parte das inovações tecnocientíficas, a reboque das decisões que são operadas no Norte global, que possui no máximo a responsabilidade com os cidadãos situados nos territórios que são sedes das grandes empresas de tecnologia.

No estágio em que estamos, os manifestos pretendem estimular o pensamento crítico sobre os desenvolvimentos da IA.

Por fim, dos pontos já abordados no manifesto anterior destaque-se:

- Como toda a população pode ser afetada pelos descaminhos do desenvolvimento tecnológicos da IA, toda ela tem o direito de se beneficiar dos seus acertos. Desse modo, a pesquisa na esfera acadêmica e científica deve ser sempre direcionada para garantir o desenvolvimento humano e bem-estar geral, incluindo a atenção ao meio ambiente e todos os seres que nele habitam. Uma maneira de garantir a inclusão é a atenção aos tópicos trazidos pela comunidade e os pesquisadores dela provenientes que ora se integram na comunidade acadêmico-científica.

- Ainda que eventualmente os interesses do mercado e da ciência possam convergir, é fundamental que a universidade estabeleça sua agenda de acordo com o interesse público, sendo os indivíduos informados e qualificados que compõem a comunidade acadêmica atores centrais deste processo, lembrando que tais indivíduos devem representar todas as parcelas da sociedade, assim como estabelecer seu interesse de pesquisa com atenção à inclusão, equidade e justiça social.

- Necessitamos conclamar representantes do Sul global que sejam capazes de estabelecer um acompanhamento dos desenvolvimentos da IA que impactam nossos territórios. Que tal acompanhamento seja feito com transparência e que se formem grupos de trabalho com chamadas abertas para reuniões incluindo pesquisadores e estudiosos do tema, assim como especialistas em áreas-chave para tais desenvolvimentos.

- Devemos demandar que todos os comitês de acompanhamento dos desenvolvimentos da IA tenham representantes do Sul global, respeitando suas diferentes linguagens e culturas.

- Fundamentalmente, o desafio da decolonialidade para as tecnologias emergentes hoje é entender que o material e o imaterial são inseparáveis; que a colonização não foi superada, ao contrário, permanece viva em práticas industriais, políticas e institucionais, e que o debate está e permanece em aberto.

Convidamos aqueles que queiram se juntar à nossa iniciativa que façam contato e expressem sua intenção através do formulário neste link.

________________

(As opiniões expressas nos artigos publicados no Jornal da USP são de inteira responsabilidade de seus autores e não refletem opiniões do veículo nem posições institucionais da Universidade de São Paulo. Acesse aqui nossos parâmetros editoriais para artigos de opinião.)