Blog

“A discussão sobre ética de IA não pode ser feita sem a participação e a responsabilidade humana, o que implica a necessidade de investimento humano”, afirma o professor Vitor Blotta - Foto: Reprodução/Pixabay

Especialistas vão debater dilemas éticos da inteligência artificial

No dia 16 de setembro, seminário na USP vai mostrar que a responsabilidade humana precisa acompanhar avanço das tecnologias

Inteligência artificial (IA) é o tipo de expressão que ainda nos remete à ficção científica, dos filmes de Stanley Kubrick e Steven Spielberg aos livros de Isaac Asimov ou William Gibson. Contudo, ela também é uma realidade muito cotidiana, fácil de ser abstraída quando se torna corriqueira. Se no dia a dia a IA não parece tão extravagante quanto já foi retratada no mundo das artes, seus dilemas éticos e suas especulações prático-filosóficas não deixam nada a dever aos mais criativos autores da literatura e do cinema.

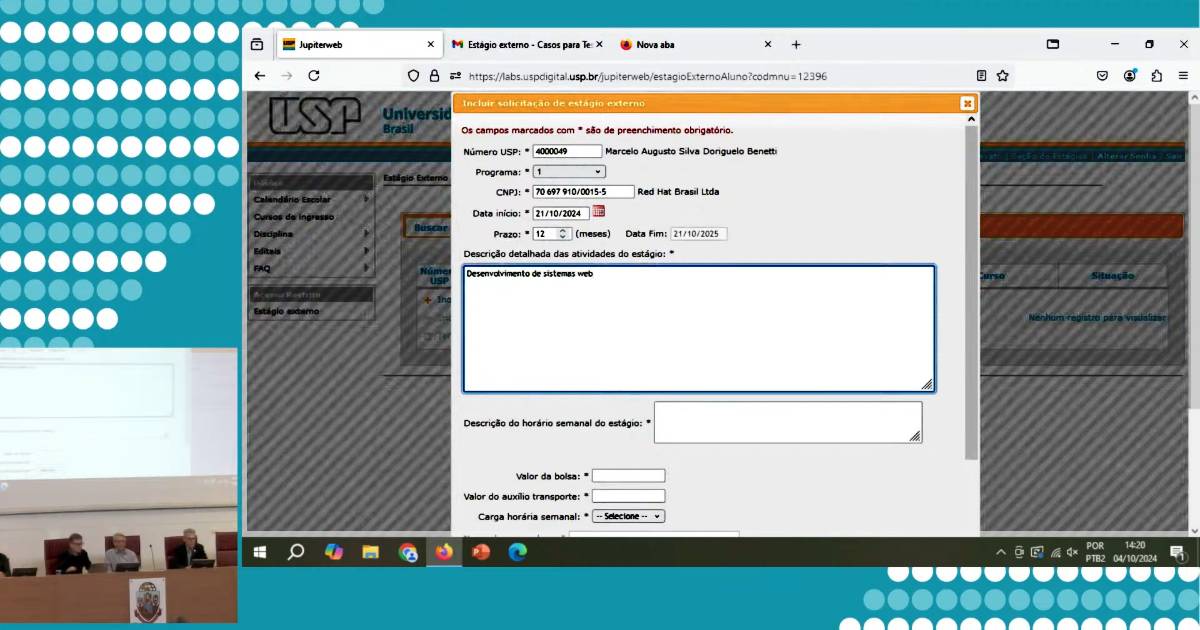

Uma parte das questões que ocupam atualmente a pauta dos especialistas será tema do seminário Ética e Inteligência Artificial, que acontece no dia 16 de setembro, das 14h às 18h30. O evento é uma iniciativa da Cátedra Oscar Sala do Instituto de Estudos Avançados (IEA) da USP e do Centro de Inteligência Artificial (C4AI), com parceria do Comitê Gestor da Internet no Brasil (CGI.br) e do Núcleo de Informação e Coordenação do Ponto BR (NIC.br).

Ao longo do seminário, pesquisadores da USP, de outras instituições de ensino e de entidades da sociedade civil abordarão os principais equívocos a respeito da IA, os prováveis riscos de seu uso generalizado e as orientações necessárias para o desenvolvimento seguro e democrático dessas tecnologias.

Os trabalhos serão abertos com a mesa IA e Mistificações, com exposição do professor Glauco Arbix, da Faculdade de Filosofia, Letras e Ciências Humanas (FFLCH) da USP, e debate entre o professor Vitor Blotta, da Escola de Comunicações e Artes (ECA) da USP, e o jornalista Caio Túlio Costa, fundador da plataforma de monitoramento digital Torabit e professor da Escola Superior de Propaganda e Marketing (ESPM).

O professor Vitor Souza Lima Blotta - Foto: Arquivo pessoal

“Uma das mistificações da IA é a ideia de uma possível consciência como a humana, no sentido de capacidade de autorreflexão e noção de temporalidade”, afirma Vitor Blotta. Segundo o professor, isso não é possível com a tecnologia atual, incluindo o deep learning, já que ela se baseia em experiências e dados passados, impedindo a elaboração de utopias e projetos menos automatizados.

Outra ilusão apontada por Blotta envolve a capacidade da inteligência artificial de tomar decisões baseadas em uma ética mais complexa, “como a ponderação de valores de mesma hierarquia, o que demanda leituras de casos concretos e menos dependentes de resultados possíveis predeterminados”, explica o professor.

Caio Túlio Costa concorda que existem muitas mistificações em torno do termo IA. Para enfrentar a questão, o jornalista sugere o ponto de vista defendido por Fei-Fei Li, professora da Universidade de Stanford que foi especialista em Ética do Google e responsável pela criação de algoritmos relacionados à IA. Segundo Costa, para Fei-Fei não existe nada de artificial na IA. Ela é inspirada e criada por pessoas e, mais importante, impacta as pessoas.

O jornalista Caio Túlio Costa - Foto: Reprodução/IEA-USP

“A principal mistificação estaria em chamar de ‘artificial’ algo profundamente humano e que é priorizado erroneamente”, pontua o jornalista, referindo-se aos bilhões gastos por governos, corporações e investidores no treino de algoritmos para a corrida pela inteligência artificial. Para Costa, é importante salientar que, enquanto tais investimentos se avolumam, a educação é subfinanciada, com professores mal pagos, escolas precárias e pouca atenção ao treinamento das crianças e de seus cérebros, superiores aos algoritmos dos computadores.

Tal opinião é partilhada por Blotta. “A discussão sobre ética de IA não pode ser feita sem a participação e a responsabilidade humana, o que implica a necessidade de investimento humano além de investimentos maquínicos”, assinala o professor.

Essa discussão sobre o que deve ser priorizado quando se fala em inteligência artificial também será abordada na mesa Expor Incerteza, Instigar Desconfiança, Evitar Falsidade: Diretrizes de Design para Interfaces de Usuário em Aprendizado de Máquina. Nela, participam da discussão o pesquisador Claudio Pinhanez, da IBM, o professor Juliano Maranhão, da Faculdade de Direito da USP, e a professora Patrícia Huelsen, da Pontifícia Universidade Católica (PUC) de São Paulo.

O professor Juliano Maranhão - Foto: Reprodução/IEA-USP

“A transparência é o pilar fundamental do design ético de sistemas de inteligência artificial, não só pelo seu valor democrático ínsito, mas também por ser instrumental para a proteção de outros direitos fundamentais, como a não discriminação, a proteção de dados pessoais e a revisão de decisões”, destaca Juliano Maranhão. “A interface com o usuário é o veículo no qual a governança transparente se concretiza, permitindo que a interação homem-máquina ocorra de modo informativo e confiável.”

Já os riscos potenciais do uso intensivo de sistemas de IA serão o assunto da mesa composta pela professora Dora Kaufmann, da PUC, do advogado Francisco de Brito Cruz, diretor do centro de pesquisa em direito e tecnologia Internetlab, e a pesquisadora Nina Santos, do Instituto Nacional de Ciência & Tecnologia em Democracia Digital (Incitdd).

“A capacidade da IA de disseminar informações de forma mais eficaz, considerando tanto o público-alvo quanto o momento e canal apropriado, é propensa a abusos e pode representar uma ameaça à democracia, ou pode contribuir positivamente”, aponta a professora Dora Kaufmann - Foto: Reprodução/Freepik

“A democracia sobreviverá ao big data e à inteligência artificial?”, questiona Dora Kaufmann. Segundo a professora, antes de mais nada é preciso ter em mente que o debate público sobre IA e democracia é polarizado. Para alguns, a inteligência artificial é uma ameaça. Para outros, uma oportunidade de aperfeiçoar as democracias. Na visão da pesquisadora, entretanto, o tema não é tão simples. “Sem dúvida, estamos no meio de uma reviravolta tecnológica que transformará a forma como a sociedade está organizada. Contudo, vale observar que nem tudo o que acontece na internet decorre das tecnologias de IA.”

Como um exemplo dessas tecnologias que se tornaram muito importantes mas não fazem parte do universo da IA, Dora cita o caso dos robôs impulsionadores, utilizados para disseminar notícias nas redes sociais e amplamente usados durante as eleições, seja para influenciar o voto, seja para fornecer argumentos para militantes. O reconhecimento de que outros fatores participam desse jogo no qual a democracia ocupa lugar de destaque, porém, não quer dizer que não haja espaço aqui para se pensar no papel da inteligência artificial.

“A capacidade da IA de disseminar informações de forma mais eficaz, considerando tanto o público-alvo quanto o momento e canal apropriados, é propensa a abusos e pode representar uma ameaça à democracia, ou pode contribuir positivamente”, realça a professora.

Dora enumera possíveis ameaças que a IA pode trazer à democracia. Em primeiro lugar, o potencial de aumentar a polarização e perpetuar preconceitos, promovendo dessa forma a divisão política entre os cidadãos. Em seguida, existe o risco de desinformação em larga escala, particularmente com o uso de deep fakes. Há também o perigo do aumento da vigilância sobre os cidadãos, com o fortalecimento do controle social a favor das autocracias. E, junto disso, o problema da moderação de conteúdo.

A professora Dora Kaufmann - Foto: Reprodução/IEA-USP

“A utilização de conteúdos personalizados, ‘microtargeting’, visando a influenciar o voto do eleitor, tem potencial de manipulação, mesmo admitindo a dificuldade de comprovar o grau de influência real nos resultados eleitorais”, afirma Dora. “Vale igualmente observar que essas potenciais externalidades negativas, ou ameaças, estão inter-relacionadas. Não são efeitos isolados.”

Mas a professora enxerga também oportunidades para o aperfeiçoamento das democracias e a promoção do bem-estar social. Dora destaca, por exemplo, a capacidade da IA de avaliar com mais precisão a vontade dos cidadãos e de filtrar e classificar conteúdos, no intuito de priorizar informações úteis e também identificar conteúdos tendenciosos. A inteligência artificial pode, além disso, ser uma aliada na personalização da comunicação entre Estado e cidadão, aprimorando a experiência dos usuários dos serviços públicos. Finalmente, ela pode prever quais projetos em tramitação no Legislativo têm mais relevância para a população e maior potencial de serem aprovados, revelando assim as tendências dos congressistas.

O Seminário Ética e Inteligência Artificial acontece no dia 16 de setembro, das 14h às 18h30, em formato híbrido (presencial e on-line), no Instituto de Estudos Avançados (IEA) da USP (Rua da Praça do Relógio, 109, na Cidade Universitária, em São Paulo). Os interessados em participar do evento presencialmente devem se inscrever neste site. Para acompanhar a transmissão on-line basta acessar o site do IEA. Grátis. Mais informações estão disponíveis neste link.

A reprodução de matérias e fotografias é livre mediante a citação do Jornal da USP e do autor. No caso dos arquivos de áudio, deverão constar dos créditos a Rádio USP e, em sendo explicitados, os autores. Para uso de arquivos de vídeo, esses créditos deverão mencionar a TV USP e, caso estejam explicitados, os autores. Fotos devem ser creditadas como USP Imagens e o nome do fotógrafo.