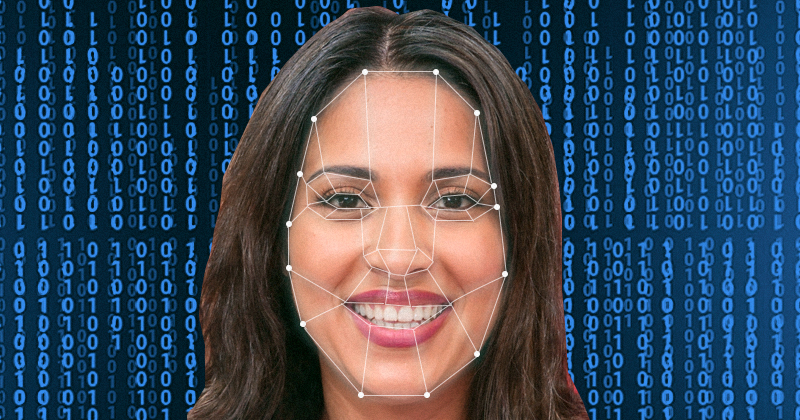

Assim como as fake news invadiram as redes sociais e os meios de comunicação, os deepfakes (na tradução literal, profundamente falsos) estão revolucionando e polemizando o universo das imagens. “Os deepfakes são imagens produzidas por processos de aprendizado maquínico (machine learning), ou seja, de Inteligência Artificial, através de uma metodologia chamada redes neurais, e que têm como principal característica serem criadas integralmente por algoritmos. Como o próprio nome diz, procura reproduzir comportamentos e mecanismos de sistemas neurais humanos”, explica a professora da Faculdade de Arquitetura e Urbanismo (FAU) da USP Giselle Beiguelman, colunista da Rádio USP (93,7 MHz). Giselle comenta o tema num artigo recém-publicado na Revista Zum, do Instituto Moreira Salles (IMS), e também numa live que acontece nesta quarta-feira, dia 29, às 18 horas, no canal daquela revista no Youtube.

Esses programas utilizam bancos de dados que reúnem milhões de imagens presentes nas redes, criando fotos e vídeos tão verossímeis que não se sabe mais o que é real ou ficção. Depois que viralizam, fica difícil contornar seus estragos, como diz Giselle. Um exemplo clássico disso é um vídeo, divulgado em abril de 2018 no site BuzzFeed, em que o ex-presidente dos Estados Unidos Barack Obama ataca os Panteras Negras – organização antirracista surgida nos anos 60, nos Estados Unidos – e xinga o atual presidente norte-americano, Donald Trump. Apesar da perfeição da imagem, o Barack Obama que aparece no vídeo é falso, um deepfake.

O fenômeno também ganha fôlego como técnica de rejuvenescimento, caso dos atores Al Pacino e Robert De Niro no filme O Irlândes (2019), de Martin Scorsese, ou nos memes engraçados – os preferidos pela professora –, mas também como temidas armas políticas capazes de transmitir discursos falsos. Segundo a professora, personalidades são as mais suscetíveis aos deepfakes, já que a quantidade de imagens dessas pessoas disponível on-line é muito maior que a de outros usuários, fornecendo mais dados para o aprendizado de seus gestos, sua fala e suas expressões faciais.

Há falhas, admite Giselle, mas quanto mais o sistema erra, mais aprende a reformular essas falhas. “Quando as imagens estão nesse sistema de programação de redes neurais, um núcleo tenta enganar o outro. É como se uma máquina tentasse enganar a outra através de imagens que não são reais. A primeira envia imagens que são devolvidas pela segunda, com informações de que ainda há aspectos que apresentam falhas. A imagem é então reformulada até chegar a um ponto em que o sistema aceita aquela imagem como real”, explica a professora. Além disso, depois que as imagens são catalogadas nesse sistema, ele se torna totalmente independente da interferência humana. “Podemos dizer que é um processo inteiramente maquínico porque, uma vez que as imagens são colocadas nesse sistema de redes neurais, só os algoritmos trabalham na produção e no desenvolvimento delas”, completa.

Alguns bugs acontecem com frequência, como foco, imagens desemparelhadas ou barulhos estranhos. “Com brincos em geral o sistema se atrapalha. Você percebe que as imagens se desemparelham, e uma orelha aparece com brinco e a outra não”, exemplifica a professora. Porém, como ela informa, é muito rápida a maturação desse sistema, e a tendência é que cada vez seja mais difícil reconhecer essas falhas, especialmente em vídeo. Para a professora, é possível perceber o quanto essa tecnologia dos deepfakes é diferente dos sistemas humanos de remixagem e de pós-reprodução, já que o sistema de áudio passa a ser sincronizado com os gestos e com os lábios, incluindo todas as nuances de modulações de voz. E essa sincronização não é feita por programas de edição de vídeo. “Talvez aí fique mais claro o processo maquínico, que é feito através da incorporação de milhões de imagens disponíveis na rede, lidando com uma amostragem diversificada e por isso muito qualificada.”

Tecnologia acessível

Em setembro de 2019, o aplicativo chinês Zao lançou a tecnologia para o usuário amador. O aplicativo, que bateu recorde de downloads, transformava, em segundos, qualquer pessoa em astro de Hollywood. Como conta Giselle em seu artigo na Revista Zum, o sucesso também levou a protestos contra violação de privacidade, fazendo com que a empresa detentora da tecnologia revogasse a premissa de que se reservava o direito de usar as imagens e as informações biométricas compartilhadas pelos seus usuários. Além disso, a nova legislação da internet chinesa, anunciada em novembro de 2019, proíbe o uso de recursos de inteligência artificial sem divulgação prévia, regulação motivada pela proliferação das fake news.

O artigo também apresenta um levantamento feito pela empresa holandesa Deeptrace, que desenvolve algoritmos para a identificação de deepfakes, mostrando que o número de vídeos deepfakes praticamente dobrou no último ano, saltando de 7.946 em dezembro de 2018 para 14.678 em dezembro de 2019 – desses vídeos, 96% são pornográficos e atingem cerca de 135 milhões de visualizações. “O uso de deepfakes na pornografia com imagens de mulheres é enorme, e a troca de rosto ainda é muito comum”, diz Giselle, informando ainda que o termo deepfake nasceu em um fórum, realizado em novembro de 2017 no Reddit, uma rede social de discussões temáticas que tratava exatamente da substituição do rosto de atrizes pornôs pelo de celebridades. Não à toa, três grandes conglomerados empresariais de tecnologia – Microsoft, Amazon e Facebook – se uniram no Desafio de Detecção de Deepfakes. Para Giselle, “isso já é suficiente para intuir a escala do problema”.

A tecnologia dos deepfakes não se relaciona somente com o presente, mas também com o passado. Na instalação No Caso de um Desastre Lunar (2019), Francesca Panetta, diretora de criação do Centro de Virtualidade Avançada do Instituto de Tecnologia de Massachusetts (MIT), nos Estados Unidos, criou, em parceria com Halsey Burgund, do Open Documentary Lab, também do MIT, um vídeo em que o presidente Richard Nixon reporta, diretamente do Salão Oval da Casa Branca, um desastre ocorrido com a missão lunar Apolo 11, em 1969. Seu discurso foi escrito por Bill Safire e seria lido no caso de um acidente que, como se sabe, não aconteceu. Segundo os autores, a obra pretende “alertar sobre os riscos de os deepfakes falsificarem não apenas o presente, mas também o passado”.

“O que precisamos entender é que os deepfakes são um tipo de rotina de programação que está disponível em vários tipos de aplicativos que usamos correntemente, e que têm vários tipos de saída. Além disso, fica muito claro como a internet reproduz exatamente as contradições do mundo real. Racismo e machismo, por exemplo, são duas questões que vão reverberar fortemente”, alerta. Prova disso está no site Esta Pessoa Não Existe (thispersondoesnotexist.com), de Philip Wang, engenheiro sênior de software da Microsoft. Como cita Giselle, no experimento conduzido por Bernardo Fontes, pesquisador do Grupo de Experiências Críticas em Infraestruturas Digitais (Gecid) do Inova-USP, observa-se no site “o grau de padronização embutido nos processos de visão computacional, reproduzindo dinâmicas raciais e de classe que prevalecem na internet”.

Questão ética

Segundo a professora Giselle, o campo da Inteligência Artificial vive um paradoxo. “Podemos dizer que é como uma briga de gato e rato. Quanto mais você sofistica as formas de reconhecimento, mais você sofistica as formas de driblar o sistema – até porque as redes neurais são exatamente isso – e, uma vez que você cria novos parâmetros que vão criando condições para se reconhecer, os sistemas tendem a amadurecer e incorporar esses padrões, e superá-los”. Segundo a professora, há uma questão ética que precisa ser discutida para além da questão da programação, assim como nas fake news. “Não dá para tratar o assunto só no plano do algoritmo. Isso depende de um padrão cultural em que essas questões estão em jogo”, afirma a professora. E questiona: que tipo de novos contextos éticos e culturais precisamos levar em consideração para lidar com um mundo onde a criação cultural já não é uma exclusividade dos humanos? Para ela, precisa haver outro reconhecimento cultural dessas instâncias. “Enquanto insistirmos em tratarmos isso no campo da programação, do meu ponto de vista, a tendência é que vamos cada vez mais alimentar o próprio sistema. Quanto mais ele erra, mais ele acerta, e esse é o paradoxo das redes neurais”, acrescenta, indicando um possível caminho: “A discussão deve ser feita a partir de novos paradigmas culturais”.

Segundo Giselle, os deepfakes vieram para ficar. “Até porque, se fosse o contrário, teríamos que ignorar a história das imagens técnicas, em que a questão da manipulação de imagens é fundamental – os processos de pós-produção, os retoques, isso é intrínseco”, explica. “O deepfake apresenta problemas éticos, mas é um universo no campo das imagens, a ser explorado no âmbito da arte e da cultura. Ele faz parte de um campo de pesquisa sobre visão computacional, que relativiza todo o nosso campo tão antropocêntrico. É um desdobramento do processo de digitalização da cultura, que tem como um de seus aspectos mais interessantes, do ponto de vista filosófico, cultural e artístico, nos obrigar a repensar a centralidade do homem nos processos de criação. Nesse sentido, o deepfake é uma luz no horizonte”, comenta. E conclui: “É bem provável que os deepfakes mudem, que possam ter outros nomes, outros usos, mas todo esse processo de codificação de visão computacional veio para ficar, e tende a aumentar”.